Le fichier robots.txt est destiné aux robots (crawlers) comme son nom l’indique. Censé bloquer l’indexation de certaines URL, son efficacité peut parfois laisser songeur…

Le fichier robots.txt est destiné aux robots (crawlers) comme son nom l’indique. Censé bloquer l’indexation de certaines URL, son efficacité peut parfois laisser songeur…

Ils peuvent cepandant être lus par les humains. Il suffit de rajouter /robots.txt à la fin d’une nom de domaine. Et cela peut parfois donner des informations intéressantes aux indiscrets! Continuer la lecture de « Robots.txt: laissons à Google ce qui lui appartient »

Catégorie : Non classé

Lister les sites web hébergés sur une même IP

Le script PHP de cet article fait suite à une petite déception du site spyonweb.com dans le jeu du moment des SEO à savoir: « Qui est Gasy? » (mystérieux blog SEO pertinent et décalé qui a fait son apparition récemment).

Le script PHP de cet article fait suite à une petite déception du site spyonweb.com dans le jeu du moment des SEO à savoir: « Qui est Gasy? » (mystérieux blog SEO pertinent et décalé qui a fait son apparition récemment).

Ma première démarche a été de vérifier la liste des autres sites hébergés sur le même serveur que gasymagnifik.com, la réponse de SpyonWeb m’ayant laissé sur ma faim… J’ai donc allié quelques lignes de code et une commande du moteur de recherche Bing afin d’avoir plus de réponses.

Continuer la lecture de « Lister les sites web hébergés sur une même IP »

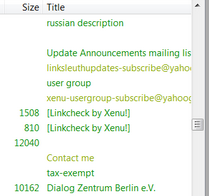

Xenu: petit bug avec la balise title

Xenu est un excellent outil gratuit pour vérifier des liens mais aussi pour récupérer l’ensemble des balises <title> et <meta description…> de toutes les pages d’un site.

Xenu est un excellent outil gratuit pour vérifier des liens mais aussi pour récupérer l’ensemble des balises <title> et <meta description…> de toutes les pages d’un site.

En faisant un crawl d’un site pour un audit avec Xenu’s Link Sleuth, un petit bug a fait son apparition: la colonne<title>déraille dans certains cas. Continuer la lecture de « Xenu: petit bug avec la balise title »

Contenu Copié ? Image trackée !

Le contenu dupliqué mais surtout le contenu volé est une véritable plaie. Nous cherchons tous à avoir du contenu unique pour ne pas passer dans le filtre Anti Duplicate Content de Google.

Grâce au HTTP_REFERER, il est possible de connaître l’URL d’un site qui ferait appel à vos images en direct. N’ayant pas codé depuis longtemps et sur une idée de l’ami @jambonbuzz (SEO chez Miwim), je me suis décidé à écrire un petit script afin de détecter les plagiaires via un tracking d’images. Continuer la lecture de « Contenu Copié ? Image trackée ! »

Encodage d’images en Base64 et vitesse de chargement

Suite à l’article de Daniel Roch sur les différentes manières pour optimiser les performances d’un thème WordPress , je voulais rajouter mon petit grain de sel sur une optimisation parfois très efficace concernant les images. Cette astuce consiste à encoder les images en Base64.

Suite à l’article de Daniel Roch sur les différentes manières pour optimiser les performances d’un thème WordPress , je voulais rajouter mon petit grain de sel sur une optimisation parfois très efficace concernant les images. Cette astuce consiste à encoder les images en Base64.

Mais c’est quoi ce « Base 64 » Aymeric? Pour ceux qui ne connaissent pas et si l’on s’en tient à la définition de Wikipédia, « base64 est un codage de l’information utilisant 64 caractères, choisis pour être disponibles sur la majorité des systèmes. » Nous allons utiliser ce codage pour représenter des données binaires dans du texte. Je vous ai perdu? déja? Bon, fin de l’intro…

Continuer la lecture de « Encodage d’images en Base64 et vitesse de chargement »

Elite Proxy Switcher, le freeware qui dépanne pour scraper

J’au eu récemment besoin de faire un scraping de PageRank pour une liste d’URL’s assez conséquente.

J’au eu récemment besoin de faire un scraping de PageRank pour une liste d’URL’s assez conséquente.

N’ayant pas ScrapeBox sous la main, et souhaitant éviter un blacklistage d’IP, j’ai demandé de l’aide à des copains SEO via Skype pour trouver un logiciel qui me permettrait d’utiliser des proxys tout en faisant de la rotation automatique pour utiliser ensuite un script maison de Scraping.

Après avoir « sonné » @Mikiweb et @FlorianKarmen, c’est @Guibfrance qui m’a donné la réponse avec un freeware: Elite Proxy Switcher. Voici un petit descriptif rapide de ce soft. Continuer la lecture de « Elite Proxy Switcher, le freeware qui dépanne pour scraper »

Compte rendu du SEOCampus 2012, un évènement SEO friendly

Malheureusement absent du SEOCampus 2011 – je l’avais suivi via un livetweet- , j’étais présent cette année In Real Life. Enfin la première journée uniquement… mais c’était déjà bien! Je vais revenir assez rapidement (enfin si ça se trouve, je vais faire plus de 1800 mots) sur les différentes conférences auxquelles j’ai pu assister ainsi que les chouettes rencontres que j’ai pu y faire. Continuer la lecture de « Compte rendu du SEOCampus 2012, un évènement SEO friendly »

Malheureusement absent du SEOCampus 2011 – je l’avais suivi via un livetweet- , j’étais présent cette année In Real Life. Enfin la première journée uniquement… mais c’était déjà bien! Je vais revenir assez rapidement (enfin si ça se trouve, je vais faire plus de 1800 mots) sur les différentes conférences auxquelles j’ai pu assister ainsi que les chouettes rencontres que j’ai pu y faire. Continuer la lecture de « Compte rendu du SEOCampus 2012, un évènement SEO friendly »

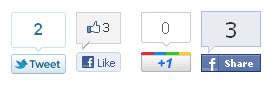

Conserver le nombre de tweets/like d’une page après une redirection 301

Je ne vous apprends rien: la majeure partie des boutons sociaux permettent d’afficher un compteur comptabilisant le nombre de tweets, like, +1 ou autres shares en tout genre. Mais en cas de modification de l’URL d’une page, en ayant pris soin de rediriger l’ancienne URL vers la nouvelle en 301, ces « votes » peuvent repartirent à 0… (dommage pour une page avec de nombreux like/retweets/share) Tout simplement parce qu’une nouvelle URL (référence) est créée et peu de réseaux sociaux Continuer la lecture de « Conserver le nombre de tweets/like d’une page après une redirection 301 »

Je ne vous apprends rien: la majeure partie des boutons sociaux permettent d’afficher un compteur comptabilisant le nombre de tweets, like, +1 ou autres shares en tout genre. Mais en cas de modification de l’URL d’une page, en ayant pris soin de rediriger l’ancienne URL vers la nouvelle en 301, ces « votes » peuvent repartirent à 0… (dommage pour une page avec de nombreux like/retweets/share) Tout simplement parce qu’une nouvelle URL (référence) est créée et peu de réseaux sociaux Continuer la lecture de « Conserver le nombre de tweets/like d’une page après une redirection 301 »

Plugin d’ajout automatique du tag more sous WordPress

« Oyé, modérateurs ou administrateurs de sites de communiqué de presse! ». Un beau matin, @Papilouve via un petit tweet cherchait un plugin pour ajouter automatiquement le tag <!–more–> dans des articles WordPress au cas où il n’aurait pas été inséré (pour les auteurs indisciplinés). Ni une, ni deux, je me lance dans la création d’un tel plugin sans me poser de questions (elle avait sûrement cherché avant quand même!). Continuer la lecture de « Plugin d’ajout automatique du tag more sous WordPress »

« Oyé, modérateurs ou administrateurs de sites de communiqué de presse! ». Un beau matin, @Papilouve via un petit tweet cherchait un plugin pour ajouter automatiquement le tag <!–more–> dans des articles WordPress au cas où il n’aurait pas été inséré (pour les auteurs indisciplinés). Ni une, ni deux, je me lance dans la création d’un tel plugin sans me poser de questions (elle avait sûrement cherché avant quand même!). Continuer la lecture de « Plugin d’ajout automatique du tag more sous WordPress »

En-tête HTTP, les bots ne parlent aucune langue

La semaine dernière, je discutais avec Hervé aka @infiniclick sur la manière de comptabiliser le nombre de lectures sur un article d’un site, dans son CMS dont le nom de code doit rester secret (fais moi confiance, je ne dévoilerai jamais ton back-office).

La semaine dernière, je discutais avec Hervé aka @infiniclick sur la manière de comptabiliser le nombre de lectures sur un article d’un site, dans son CMS dont le nom de code doit rester secret (fais moi confiance, je ne dévoilerai jamais ton back-office).

Mais un problème se posait: comment comptabiliser le nombre de vues d’un billet sans prendre en compte les différents bots qui visitent une URL dès qu’elle vient d’être tweetée (comme l’ami Twitterbot) ?

Continuer la lecture de « En-tête HTTP, les bots ne parlent aucune langue »